- VOX

- Data Protection

- NetBackup

- Re: Netbackup 9.1 I want to Duplicate to one tape

- Subscribe to RSS Feed

- Mark Topic as New

- Mark Topic as Read

- Float this Topic for Current User

- Bookmark

- Subscribe

- Mute

- Printer Friendly Page

- Mark as New

- Bookmark

- Subscribe

- Mute

- Subscribe to RSS Feed

- Permalink

- Report Inappropriate Content

04-05-2022 05:10 AM - edited 04-05-2022 07:57 AM

- I want to Duplicate to one tape

200 GB of data to be Duplicate

However, while receiving 4079L3 Duplicate, the last one is mounted on 4087L3 and Duplicate is performed on another tape. Is there a policy of backing up to one tape? For reference, the current configuration is run as the vault manager.

2022. 3. 29 2:54:22 - begin Duplicate

2022. 3. 29 2:54:22 - requesting resource nbudr-hcart3-robot-tld-0

2022. 3. 29 2:54:22 - requesting resource @aaaab

2022. 3. 29 2:54:22 - reserving resource @aaaab

2022. 3. 29 2:54:22 - resource @aaaab reserved

2022. 3. 29 2:54:22 - granted resource 4079L3

2022. 3. 29 2:54:22 - granted resource IBM.ULT3580-TD3.000

2022. 3. 29 2:54:22 - granted resource nbudr-hcart3-robot-tld-0

2022. 3. 29 2:54:22 - granted resource MediaID=@aaaab;DiskVolume=PureDiskVolume;DiskPool=dp_disk_nbudr;Path=PureDiskVolume;StorageServer=nbudr;MediaServer=nbudr

2022. 3. 29 2:54:23 - Info bptm (pid=163690) start

2022. 3. 29 2:54:23 - started process bptm (pid=163690)

2022. 3. 29 2:54:23 - Info bptm (pid=163690) start backup

2022. 3. 29 2:54:23 - Info bpdm (pid=163713) started

2022. 3. 29 2:54:23 - started process bpdm (pid=163713)

2022. 3. 29 2:54:23 - Info bpdm (pid=163713) reading backup image

2022. 3. 29 2:54:23 - Info bpdm (pid=163713) using 30 data buffers

2022. 3. 29 2:54:23 - Info bpdm (pid=163713) requesting nbjm for media

2022. 3. 29 2:54:23 - Info bptm (pid=163690) Waiting for mount of media id 4079L3 (copy 2) on server nbudr.

2022. 3. 29 2:54:23 - started process bptm (pid=163690)

2022. 3. 29 2:54:23 - mounting 4079L3

2022. 3. 29 2:54:23 - Info bptm (pid=163690) INF - Waiting for mount of media id 4079L3 on server nbudr for writing.

2022. 3. 29 2:54:23 - begin reading

2022. 3. 29 2:55:26 - Info bptm (pid=163690) media id 4079L3 mounted on drive index 0, drivepath /dev/tape/by-path/pci-0000:19:00.1-fc-0x2002000e1112ce1f-lun-0-nst, drivename IBM.ULT3580-TD3.000, copy 2

2022. 3. 29 2:55:30 - Info bptm (pid=163690) waited for full buffer 0 times, delayed 0 times

2022. 3. 29 2:55:30 - end reading; read time: 0:01:07

2022. 3. 29 2:55:30 - Info bpdm (pid=163713) completed reading backup image

2022. 3. 29 2:55:30 - Info bpdm (pid=163713) using 30 data buffers

2022. 3. 29 2:55:31 - begin reading

2022. 3. 29 2:55:31 - Info bptm (pid=163690) waited for full buffer 0 times, delayed 0 times

2022. 3. 29 2:55:32 - end reading; read time: 0:00:01

2022. 3. 29 2:55:32 - Info bpdm (pid=163713) completed reading backup image

2022. 3. 29 2:55:32 - Info bpdm (pid=163713) using 30 data buffers

2022. 3. 29 2:55:32 - begin reading

2022. 3. 29 2:55:32 - Info bptm (pid=163690) waited for full buffer 0 times, delayed 0 times

2022. 3. 29 2:55:33 - end reading; read time: 0:00:01

2022. 3. 29 2:55:33 - Info bpdm (pid=163713) completed reading backup image

2022. 3. 29 2:55:33 - Info bpdm (pid=163713) using 30 data buffers

2022. 3. 29 2:55:33 - begin reading

2022. 3. 29 2:55:33 - Info bptm (pid=163690) waited for full buffer 2 times, delayed 2 times

2022. 3. 29 2:55:34 - end reading; read time: 0:00:01

2022. 3. 29 2:55:34 - Info bpdm (pid=163713) completed reading backup image

2022. 3. 29 2:55:34 - Info bpdm (pid=163713) using 30 data buffers

2022. 3. 29 2:55:34 - begin reading

2022. 3. 29 2:55:36 - Info bptm (pid=163690) waited for full buffer 82 times, delayed 91 times

2022. 3. 29 2:55:37 - end reading; read time: 0:00:03

2022. 3. 29 2:55:37 - Info bpdm (pid=163713) completed reading backup image

2022. 3. 29 2:55:38 - Info bpdm (pid=163713) using 30 data buffers

2022. 3. 29 2:55:38 - begin reading

2022. 3. 29 2:55:41 - Info bptm (pid=163690) waited for full buffer 130 times, delayed 136 times

2022. 3. 29 2:55:44 - end reading; read time: 0:00:06

2022. 3. 29 2:55:44 - Info bpdm (pid=163713) completed reading backup image

2022. 3. 29 2:55:44 - Info bpdm (pid=163713) using 30 data buffers

2022. 3. 29 2:55:45 - begin reading

2022. 3. 29 3:06:10 - Info bptm (pid=163690) waited for full buffer 20575 times, delayed 27893 times

2022. 3. 29 3:06:12 - end reading; read time: 0:10:27

2022. 3. 29 3:06:12 - Info bpdm (pid=163713) completed reading backup image

2022. 3. 29 3:06:12 - Info bpdm (pid=163713) using 30 data buffers

2022. 3. 29 3:06:13 - begin reading

2022. 3. 29 3:16:42 - Info bptm (pid=163690) waited for full buffer 20977 times, delayed 28064 times

2022. 3. 29 3:16:44 - end reading; read time: 0:10:31

2022. 3. 29 3:16:44 - Info bpdm (pid=163713) completed reading backup image

2022. 3. 29 3:16:44 - Info bpdm (pid=163713) using 30 data buffers

2022. 3. 29 3:16:44 - begin reading

2022. 3. 29 3:27:37 - Info bptm (pid=163690) waited for full buffer 22091 times, delayed 29364 times

2022. 3. 29 3:27:43 - Info bptm (pid=163690) EXITING with status 0 <----------

2022. 3. 29 3:27:43 - end reading; read time: 0:10:59

2022. 3. 29 3:27:43 - Info bpdm (pid=163713) completed reading backup image

2022. 3. 29 3:27:43 - Info bpdm (pid=163713) EXITING with status 0

2022. 3. 29 3:27:43 - Info nbudr (pid=163713) StorageServer=PureDisk:nbudr; Report=PDDO Stats for (nbudr): read: 115233125 KB, CR received: 82996761 KB, CR received over FC: 0 KB, dedup: 0.0%

2022. 3. 29 3:27:43 - requesting resource @aaaab

2022. 3. 29 3:27:43 - granted resource MediaID=@aaaab;DiskVolume=PureDiskVolume;DiskPool=dp_disk_nbudr;Path=PureDiskVolume;StorageServer=nbudr;MediaServer=nbudr

2022. 3. 29 3:27:44 - Info bptm (pid=203803) start

2022. 3. 29 3:27:44 - started process bptm (pid=203803)

2022. 3. 29 3:27:44 - Info bptm (pid=203803) start backup

2022. 3. 29 3:27:44 - Info bpdm (pid=203845) started

2022. 3. 29 3:27:44 - started process bpdm (pid=203845)

2022. 3. 29 3:27:44 - Info bpdm (pid=203845) reading backup image

2022. 3. 29 3:27:44 - Info bpdm (pid=203845) using 30 data buffers

2022. 3. 29 3:27:44 - Info bpdm (pid=203845) requesting nbjm for media

2022. 3. 29 3:27:44 - Info bptm (pid=203803) Waiting for mount of media id 4087L3 (copy 2) on server nbudr.

2022. 3. 29 3:27:44 - started process bptm (pid=203803)

2022. 3. 29 3:27:44 - mounting 4087L3

2022. 3. 29 3:27:44 - Info bptm (pid=203803) INF - Waiting for mount of media id 4087L3 on server nbudr for writing.

2022. 3. 29 3:27:44 - requesting resource nbudr-hcart3-robot-tld-0

2022. 3. 29 3:27:44 - granted resource 4087L3

2022. 3. 29 3:27:44 - granted resource IBM.ULT3580-TD3.001

2022. 3. 29 3:27:44 - granted resource nbudr-hcart3-robot-tld-0

2022. 3. 29 3:27:45 - begin reading

2022. 3. 29 3:28:28 - Info bptm (pid=203803) media id 4087L3 mounted on drive index 1, drivepath /dev/tape/by-path/pci-0000:18:00.1-fc-0x2008000e1112ce1f-lun-0-nst, drivename IBM.ULT3580-TD3.001, copy 2

2022. 3. 29 3:39:32 - Info bptm (pid=203803) waited for full buffer 22098 times, delayed 29691 times

2022. 3. 29 3:39:38 - Info bptm (pid=203803) EXITING with status 0 <----------

2022. 3. 29 3:39:39 - end reading; read time: 0:11:54

2022. 3. 29 3:39:39 - Info bpdm (pid=203845) completed reading backup image

2022. 3. 29 3:39:39 - Info bpdm (pid=203845) EXITING with status 0

2022. 3. 29 3:39:39 - Info nbudr (pid=203845) StorageServer=PureDisk:nbudr; Report=PDDO Stats for (nbudr): read: 40620064 KB, CR received: 28672781 KB, CR received over FC: 0 KB, dedup: 0.0%

2022. 3. 29 3:39:39 - end Duplicate; elapsed time 0:45:17

The requested operation was successfully completed. (0)

Solved! Go to Solution.

Accepted Solutions

- Mark as New

- Bookmark

- Subscribe

- Mute

- Subscribe to RSS Feed

- Permalink

- Report Inappropriate Content

04-05-2022 05:19 AM

The first image was copied using nbudr-hcart3-robot-tld-0 and the second using nbudr-hcart3-robot-tld-1.

that is the possible cause of using two tapes.

why?

I do not have and answer. But you can solve this by changing the "maximum number of partially full media" to 1 at the volume pool properties

- Mark as New

- Bookmark

- Subscribe

- Mute

- Subscribe to RSS Feed

- Permalink

- Report Inappropriate Content

04-05-2022 05:47 AM

yes.

If you put 1, netbackup will not ask for a new tape before the tape gets full, unless you use different retention or take the tape out of the library

- Mark as New

- Bookmark

- Subscribe

- Mute

- Subscribe to RSS Feed

- Permalink

- Report Inappropriate Content

04-05-2022 05:19 AM

The first image was copied using nbudr-hcart3-robot-tld-0 and the second using nbudr-hcart3-robot-tld-1.

that is the possible cause of using two tapes.

why?

I do not have and answer. But you can solve this by changing the "maximum number of partially full media" to 1 at the volume pool properties

- Mark as New

- Bookmark

- Subscribe

- Mute

- Subscribe to RSS Feed

- Permalink

- Report Inappropriate Content

04-05-2022 05:44 AM

There are now 40 tapes in the scratch pool. When Duplicate starts, one tape is moved to the DB_DATA pool. Then, can I change the value of "maximum number of partially full media" to '1' in DB_DATA pool?

- Mark as New

- Bookmark

- Subscribe

- Mute

- Subscribe to RSS Feed

- Permalink

- Report Inappropriate Content

04-05-2022 05:47 AM

yes.

If you put 1, netbackup will not ask for a new tape before the tape gets full, unless you use different retention or take the tape out of the library

- Mark as New

- Bookmark

- Subscribe

- Mute

- Subscribe to RSS Feed

- Permalink

- Report Inappropriate Content

04-05-2022 06:49 AM - edited 04-05-2022 06:54 AM

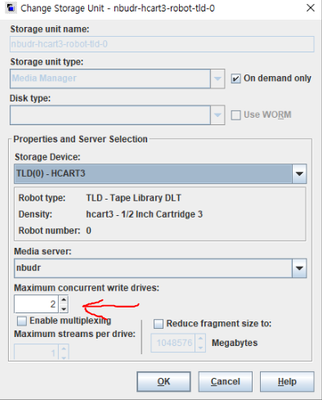

I tried changing the "maximum concurrent write drives" value to 1. I think this was the wrong way. Thank you very much, I will try to solve it tomorrow.

- Duplication to tape via BYO media server opinion. in NetBackup Appliance

- Duplicate/copy backup images from tape to tape in Backup Exec

- Duplicating tapes fails: INF - Cannot obtain resources for this job : error [167] in NetBackup

- Please tell me how to change the tape media label. in NetBackup

- Error Backup Snapshot Vmware in NetBackup